發布日期:2022-10-09 點擊率:57

在生活或工作中,人們經常面臨各種各樣的選擇,很迷茫和困惑,正確的決策非常重要。同樣,人工智能研究中也會遇到決策問題,今天就跟大家聊聊人工智能之決策樹。

決策樹(DecisionTree)是一類常見的機器學習方法。決策樹(DT)在人工智能中所處的位置:

人工智能->機器學習->監督學習->決策樹。

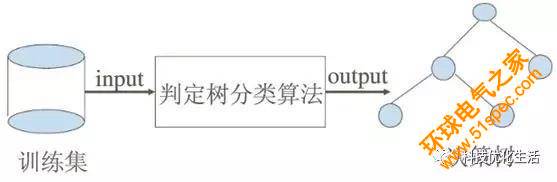

在機器學習中,決策樹(DT)是一個預測(決策)模型,它所代表的是對象屬性與對象值之間的一種映射關系。決策樹算法根據數據的屬性采用樹狀結構建立決策模型。

什么是決策樹?

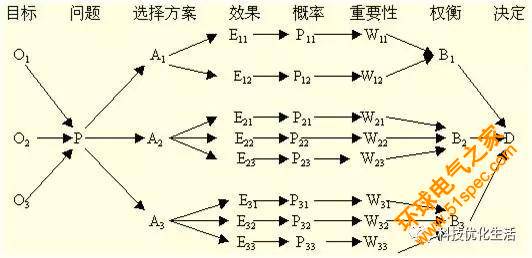

決策樹(DT)是在已知各種情況發生概率的基礎上,通過構成決策樹來求取凈現值的期望值大于等于零的概率,評價項目風險,判斷其可行性的決策分析方法,是直觀運用概率分析的一種圖解法。由于這種決策分支畫成圖形很像一棵樹的枝干,故稱決策樹。從數據產生決策樹的機器學習技術叫做決策樹學習。

通過定義我們知道,決策樹(DT)是一種樹形結構,樹中每個節點表示某個對象,而每個分叉路徑則代表的某個可能的屬性值,而每個葉結點則對應從根節點到該葉節點所經歷的路徑所表示的對象的值。結點有兩種類型:內部節點和葉節點,內部節點表示一個特征、屬性或一個屬性上的測試,每個分支代表一個測試輸出,葉節點表示一個類別。決策樹(DT)一般都是自上而下的來生成的。每個決策或事件(即自然狀態)都可能引出兩個或多個事件,導致不同的結果。

決策樹(DT)是一種十分常見的分類方法,也稱分類樹。它是一種監督學習,即給定一堆樣本,每個樣本都有一組屬性和一個類別,這些類別是事先確定的,那么通過學習得到一個分類器,這個分類器能夠對新出現的對象給出正確的分類。因此,決策樹常常用來解決分類和回歸問題。

決策樹構成要素:

1)決策結點:用方塊結點□表示,是對幾種可能方案的選擇,即最后選擇的最佳方案。如果決策屬于多級決策,則決策樹的中間可以有多個決策點,以決策樹根部的決策點為最終決策方案。

2)方案枝:由結點引出若干條細支,每條細支代表一個方案,稱為方案枝

3)狀態結點:用圓形結點○表示,代表備選方案的經濟效果(期望值),通過各狀態節點的經濟效果的對比,按照一定的決策標準就可以選出最佳方案。

4)概率枝:由狀態節點引出的分支稱為概率枝,概率枝的數目表示可能出現的自然狀態數目。每個分枝上要注明該狀態的內容和其出現的概率。

5)結果結點:用三角結點△表示,將每個方案在各種自然狀態下取得的收益值或損失值標注于結果節點的右端。

總之,決策樹一般由決策結點、方案枝、狀態結點、概率枝和結果結點等組成,這樣樹形圖由左向右或自上而下,由簡到繁展開,組成一個樹狀網絡圖。

決策樹學習過程:

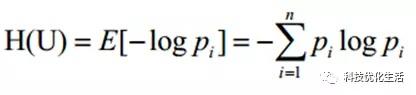

決策樹學習過程(建樹過程)包含特征選擇、決策樹的生成與剪枝過程。決策樹的學習算法通常是遞歸地選擇最優特征,并用最優特征對數據集進行分割。開始時,構建根結點,選擇最優特征,該特征有幾種值就分割為幾個子集,每個子集分別遞歸調用此方法,返回結點,返回的結點就是上一層的子結點。直到所有特征都已經用完,或者數據集只有一維特征為止。另外,隨機森林分類器將許多決策樹結合起來以提升分類的正確率。

決策樹建樹過程的主要挑戰是確定哪些屬性作為根節點以及每個級別的節點。處理這些需要知道屬性選擇。目前主要有2種不同的屬性選擇方法(信息增益和基尼指數)來識別這些屬性。當信息增益作為標準時,假設屬性是分類的;對于基尼系數,則假設屬性是連續的。

下一篇: PLC、DCS、FCS三大控

上一篇: 索爾維全系列Solef?PV