AI 芯片的誕生

講到半導(dǎo)體,不得不從摩爾定律說起。從Intel創(chuàng)始人戈登·摩爾提出摩爾定律到現(xiàn)在已經(jīng)53年了。過去的53年中,半導(dǎo)體行業(yè)一直受著摩爾定律的指導(dǎo)。芯片越做越小,單位面積的晶體管越來越多,功耗越來越低,價格越來越便宜,也使得這個行業(yè)過去五十多年來一直保持不錯的增長趨勢。網(wǎng)上對AI芯片的剖析實(shí)在太少,這里對一些論文和大佬的研究做一個總結(jié),希望對讀者有所幫助。

但是半導(dǎo)體行業(yè)風(fēng)險高、投資大、回報相對來說又比較低的特點(diǎn)使風(fēng)投對半導(dǎo)體行業(yè)的投資在過去十來年一直不溫不火,甚至是持續(xù)下降的趨勢。尤其是現(xiàn)在到了后智能手機(jī)時代或者說后摩爾時代,半導(dǎo)體急需新的技術(shù)或者新的應(yīng)用場景來推動其發(fā)展。那么新的技術(shù)和新的應(yīng)用場景是什么呢?

其實(shí)戈登·摩爾在五十三年前已經(jīng)說了“集成電路會帶來家用電腦或者至少是和中央電腦所連接的終端設(shè)備、自動駕駛、個人便攜通訊設(shè)備等”。沒錯,智能手機(jī)后下一個推動集成電路發(fā)展的新的應(yīng)用場景是自動駕駛和物聯(lián)網(wǎng)。

除了新的應(yīng)用場景外,新的技術(shù)革命也必須為半導(dǎo)體發(fā)展提供動力,新的技術(shù)革命是什么呢,沒錯,就是人工智能。人工智能的出現(xiàn)可以說讓所有行業(yè)眼前一亮,剛剛提到的無人駕駛,物聯(lián)網(wǎng)等等背后也都是因?yàn)?AI 的出現(xiàn)才帶來這樣巨大的,有前景的應(yīng)用。也就是說 AI 技術(shù)的變革才是集成電路新應(yīng)用場景落地的本質(zhì)所在。

我們知道上游芯片公司的發(fā)展一向是穩(wěn)中緩進(jìn),為什么說 AI 的發(fā)展會使芯片再次火熱起來?

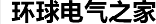

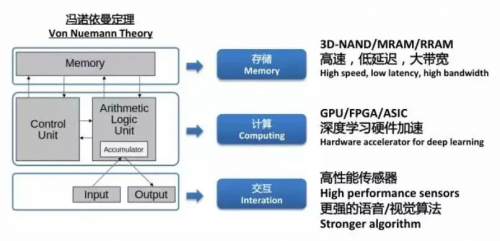

我們可以把馮諾依曼架構(gòu)的五大組成部分分為三類,輸入輸出歸類于交互,控制和邏輯歸類于計算,存儲單獨(dú)列為一類,也就是交互、計算和存儲三部分。而傳統(tǒng)的計算力無法滿足深度學(xué)習(xí)大量數(shù)據(jù)的運(yùn)算,深度學(xué)習(xí)對這三方面都提出了非常多的創(chuàng)新要求,故新的計算架構(gòu)需要為 AI 算法提供支撐。

下面我們從以上三點(diǎn)闡述下目前比較主流的深度學(xué)習(xí)在芯片層面實(shí)現(xiàn)加速的方法。

AI 芯片的加速原理

乘加運(yùn)算硬件加速,脈沖陣列

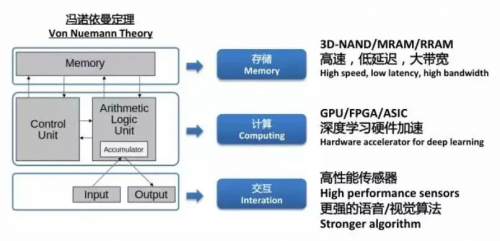

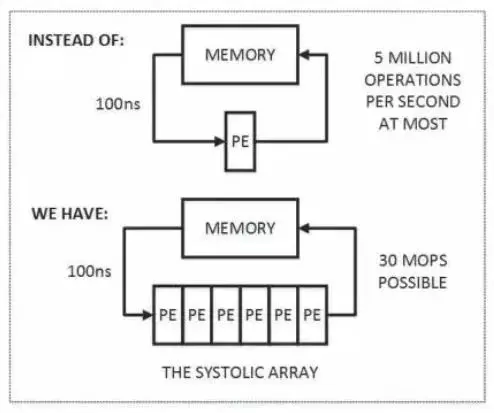

脈動陣列并不是一個新鮮的詞匯,在計算機(jī)體系架構(gòu)里面已經(jīng)存在很長時間。大家可以回憶下馮諾依曼架構(gòu),很多時候數(shù)據(jù)一定是存儲在memory里面的,當(dāng)要運(yùn)算的時候需要從memory里面?zhèn)鬏數(shù)紹uffer或者Cache里面去。當(dāng)我們使用computing的功能來運(yùn)算的時候,往往computing消耗的時間并不是瓶頸,更多的瓶頸在于memory的存和取。所以脈動陣列的邏輯也很簡單,既然memory讀取一次需要消耗更多的時間,脈動陣列盡力在一次memory讀取的過程中可以運(yùn)行更多的計算,來平衡存儲和計算之間的時間消耗。

下面說下脈沖陣列的基本原理:

首先,圖中上半部分是傳統(tǒng)的計算系統(tǒng)的模型。一個處理單元(PE)從存儲器(memory)讀取數(shù)據(jù),進(jìn)行處理,然后再寫回到存儲器。這個系統(tǒng)的最大問題是:數(shù)據(jù)存取的速度往往大大低于數(shù)據(jù)處理的速度。因此,整個系統(tǒng)的處理能力(MOPS,每秒完成的操作)很大程度受限于訪存的能力。這個問題也是多年來計算機(jī)體系結(jié)構(gòu)研究的重要課題之一,可以說是推動處理器和存儲器設(shè)計的一大動力。而脈動架構(gòu)用了一個很簡單的方法:讓數(shù)據(jù)盡量在處理單元中多流動一會兒。

正如上圖的下半部分所描述的,第一個數(shù)據(jù)首先進(jìn)入第一個PE,經(jīng)過處理以后被傳遞到下一個PE,同時第二個數(shù)據(jù)進(jìn)入第一個PE。以此類推,當(dāng)?shù)谝粋€數(shù)據(jù)到達(dá)最后一個PE,它已經(jīng)被處理了多次。所以,脈動架構(gòu)實(shí)際上是多次重用了輸入數(shù)據(jù)。因此,它可以在消耗較小的memory帶寬的情況下實(shí)現(xiàn)較高的運(yùn)算吞吐率。

上面這張圖非常直觀的從一維數(shù)據(jù)流展示了脈動陣列的簡單邏輯。當(dāng)然,對于CNN等神經(jīng)網(wǎng)絡(luò)來說,很多時候是二維的矩陣。所以,脈動陣列從一維到二維也能夠非常契合CNN的矩陣乘加的架構(gòu)。

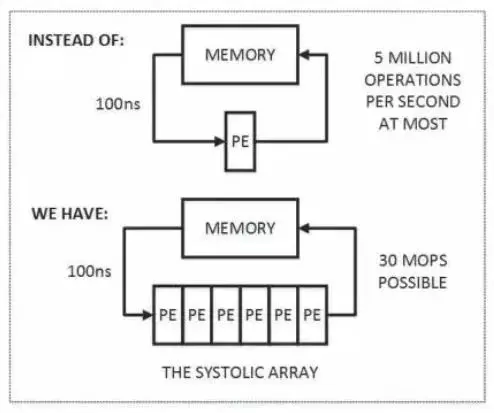

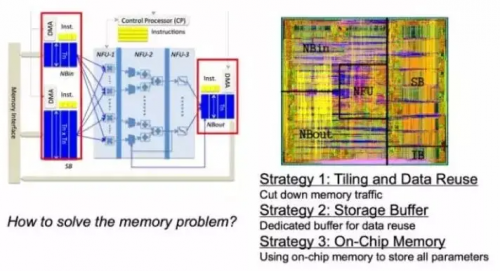

優(yōu)化 Memory 讀取

還可以從體系架構(gòu)上對整個的Memory讀取來做進(jìn)一步的優(yōu)化。這里摘取的是寒武紀(jì)展示的一些科研成果。其實(shí)比較主流的方式就是盡量做Data Reuse,減少片上Memory和片外Memory的信息讀取次數(shù),增加片上memory,因?yàn)槠蠑?shù)據(jù)讀取會更快一點(diǎn),這種方式也能夠盡量降低Memory讀取所消耗的時間,從而達(dá)到運(yùn)算的加速。

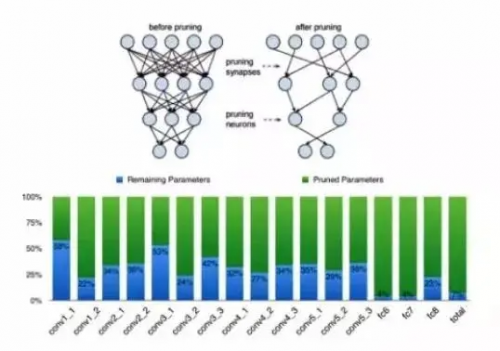

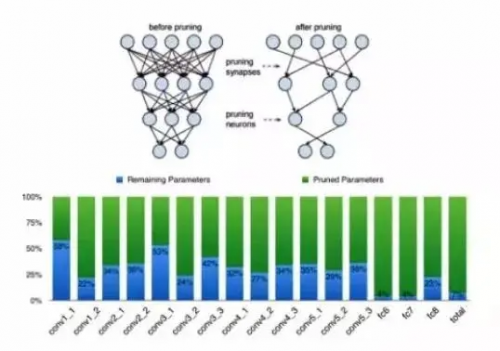

對于神經(jīng)網(wǎng)絡(luò)來說,其實(shí)很多的連接并不是一定要存在的,也就是說我去掉一些連接,可能壓縮后的網(wǎng)絡(luò)精度相比壓縮之前并沒有太大的變化。基于這樣的理念,很多剪枝的方案也被提了出來,也確實(shí)從壓縮的角度帶來了很大效果提升。

需要特別提出的是,大家從圖中可以看到,深度學(xué)習(xí)神經(jīng)網(wǎng)絡(luò)包括卷積層和全連接層兩大塊,剪枝對全連接層的壓縮效率是最大的。下面柱狀圖的藍(lán)色部分就是壓縮之后的系數(shù)占比,從中可以看到剪枝對全連接層的壓縮是最大的,而對卷積層的壓縮效果相比全連接層則差了很多。

所以這也是為什么,在語音的加速上很容易用到剪枝的一些方案,但是在機(jī)器視覺等需要大量卷積層的應(yīng)用中剪枝效果并不理想。

權(quán)重系數(shù)壓縮

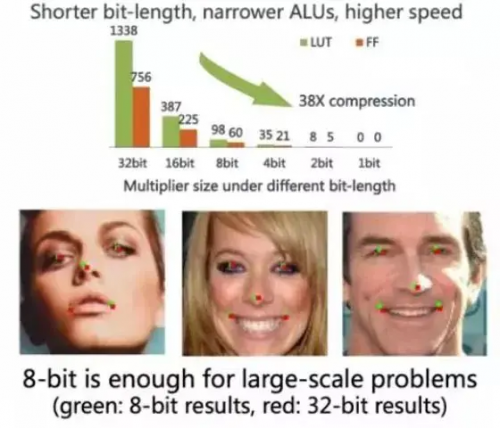

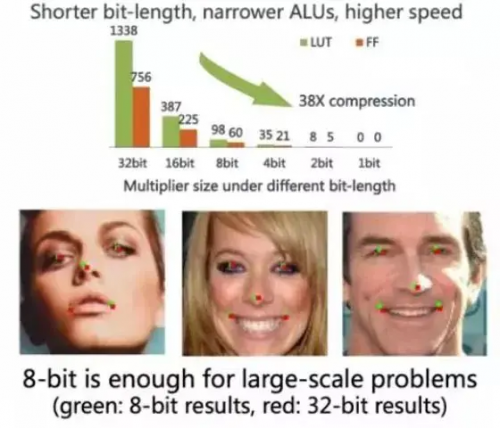

對于整個Deep Learning網(wǎng)絡(luò)來說,每個權(quán)重系數(shù)是不是一定要浮點(diǎn)的,定點(diǎn)是否就能滿足?定點(diǎn)是不是一定要32位的?很多人提出8位甚至1位的定點(diǎn)系數(shù)也能達(dá)到很不錯的效果,這樣的話從系數(shù)壓縮來看就會有非常大的效果。從下面三張人臉識別的紅點(diǎn)和綠點(diǎn)的對比,就可以看到其實(shí)8位定點(diǎn)系數(shù)在很多情況下已經(jīng)非常適用了,和32位定點(diǎn)系數(shù)相比并沒有太大的變化。所以,從這個角度來說,權(quán)重系數(shù)的壓縮也會帶來網(wǎng)絡(luò)模型的壓縮,從而帶來計算的加速。

當(dāng)然,一個不能回避的問題是計算和存儲之間的存儲墻到現(xiàn)在為止依然存在,仍然有大量的時間消耗在和存儲相關(guān)的操作上。

一個很簡單直觀的技術(shù)解決方式,就是堆疊更多更快速更高效的存儲,HBM孕育而生,也即在運(yùn)算芯片的周圍堆疊出大量的3D Memory,通過通孔來連接,不需要與片外的接口進(jìn)行交互,從而大大降低存儲墻的限制。

更有甚者提出說,存儲一定要和計算分離嗎,存儲和運(yùn)算是不是可以融合在一起,PIM(Processing in Memory)的概念應(yīng)運(yùn)而生。

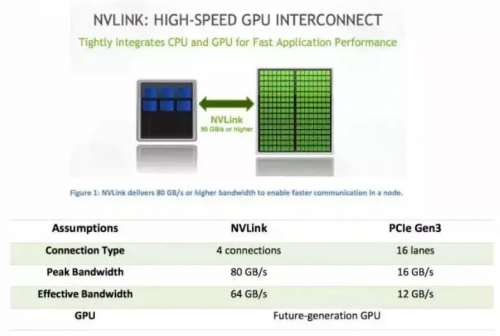

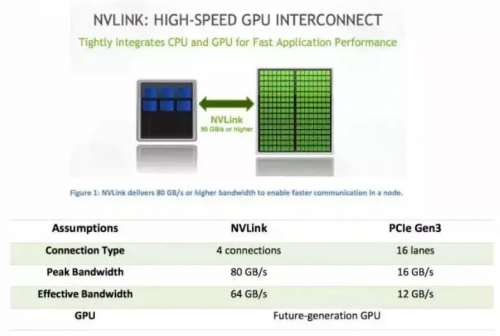

除了前面說到存儲內(nèi)置,以及存儲與運(yùn)算的融合,有沒有一個更快的接口能夠加速和片外Memory的交互也是一個很好的方向。其實(shí)上面這個概念是NVIDIA提出來的interface(接口),叫做NVLink。下面的表展示的是NVLink和PCIe Gen3的對比。大家平時看到跟存儲相關(guān)的的PCIe卡可能是PCIe Gen3 by 4,只有4個lanes和Memory對接,但是NVLink與有16個PCIe的lanes的PCIe Gen3對比,速度也有很大的提升,可以看到NVLink在速度層面是一個非常好的interface。

上面講了一些比較經(jīng)典的加速方法。下面分享幾個已經(jīng)存在的AI加速芯片的例子,相信這樣會更加直觀。

AI 芯片實(shí)例

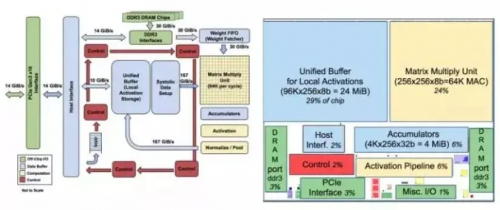

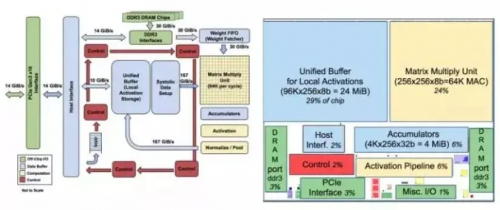

這是Google的TPU。從上邊的芯片框圖可以看到,有一個64K的乘加MAC陣列對乘加運(yùn)算進(jìn)行加速。從論文中可以看到里面已經(jīng)用到了脈動陣列的架構(gòu)方法來對運(yùn)算進(jìn)行加速,另外也有我們前面提到的大量的片上Memory 這樣的路徑。上面藍(lán)色框圖中大家可以看到有一個24MiB的片上Memory,而且有兩個高速DDR3接口能夠與片外的DDR做交互。

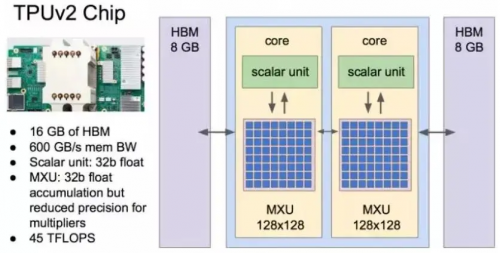

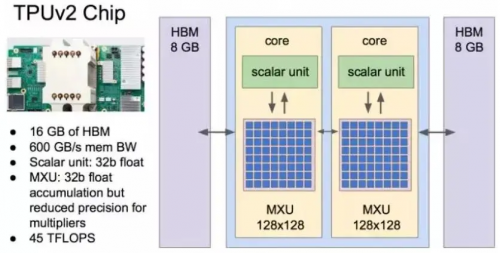

TPUv2

上圖展示的第二代TPU。從圖中可以很直觀的看到,它用到了我們前面所說到的HBM Memory。從其論文披露的信息也可以看到,二代TPU在第一代的基礎(chǔ)上增加了我們前面說到的剪枝,權(quán)重壓縮等方面做了很多嘗試,也是一個非常經(jīng)典的云端AI加速芯片的例子。

接下來跟大家分享幾個終端做Inference的例子。

Rokid

這一個是Rokid和杭州國芯共同打造的一顆針對智能音箱的SoC,AI加速只是里面的一個功能。通過上面右邊的框圖可以看到里面集成了Cadence的DSP,還有自己設(shè)計的語音加速硬件IP——NPU。這款芯片還集成了一些實(shí)現(xiàn)智能音箱必要的interface,最值得一提的是在SiP層面封裝了Embedded DRAM,可以更好的在系統(tǒng)層面實(shí)現(xiàn)數(shù)據(jù)的交互,實(shí)現(xiàn)存儲和運(yùn)算的加速,也實(shí)現(xiàn)了AI加速的功能。

HiSilicon Hi3559A

這是一款華為海思最新的IP Camera芯片——3559A,從集成度以及整個設(shè)計的均衡性來說,都令人眼前一亮。可以看下右上角幾個藍(lán)色的標(biāo)準(zhǔn)模塊,里面集成的是海思自主研發(fā)的做推理的IP——NNIE,同時還集成了Tensilica DSP,在靈活性和擴(kuò)展度上做了一個非常好的補(bǔ)充。